Unsicherheitsschätzung

Wissen, wie viel man nicht weiß

Insbesondere in sicherheitskritischen Anwendungen wie dem autonomen Fahren müssen KI-Modelle zuverlässig arbeiten. Daher ist es wichtig, Unsicherheiten in den Vorhersagen der Modelle einschätzen und mitigieren zu können. Modelle des Maschinellen Lernens, insbesondere tiefe neuronale Netze, erzielen in vielen Fällen Ergebnisse, die mit dem menschlichen Niveau vergleichbar sind oder es sogar übertreffen. Dennoch machen sie auch Fehler, die sich manchmal nicht vermeiden lassen – wenn beispielsweise die gegebenen Daten keine perfekte Vorhersage zulassen.

In vielen Fällen sind derartige Fehler unkritisch, vor allem dann, wenn diese leicht erkannt werden können und sich der Vorgang beliebig wiederholen lässt. Andererseits existieren kritische Anwendungsfälle, bei denen fehlerhafte KI-Vorhersagen z.B. zu Personenschäden oder finanziellen Verlusten führen können.

Konzept Unsicherheitsbewertung & Unsere Methode – Wasserstein Dropout

Um die Risiken in diesen Fällen abzuschwächen, können mithilfe einer gut kalibrierten Schätzung der Ausgabesicherheit, wie beispielsweise mit der am Fraunhofer IAIS entwickelten Methode »Wasserstein Dropout«, zwei Strategien verfolgt werden: Erstens können die auffallenden problematischen Ausgaben erkannt werden, sodass Fehler vermieden und die Zuverlässigkeit erhöht wird. Zweitens macht das Erkennen problematischer Ausgaben den menschlichen Eingriff oder anderweitige Mitigationsstrategien erst möglich. Wenn so die verschiedenen Modellausgaben mit einer quantifizierten Aussage über deren Unsicherheit angereichert werden, kann dies als wichtiger Baustein für eine Absicherungsargumentation genutzt werden.

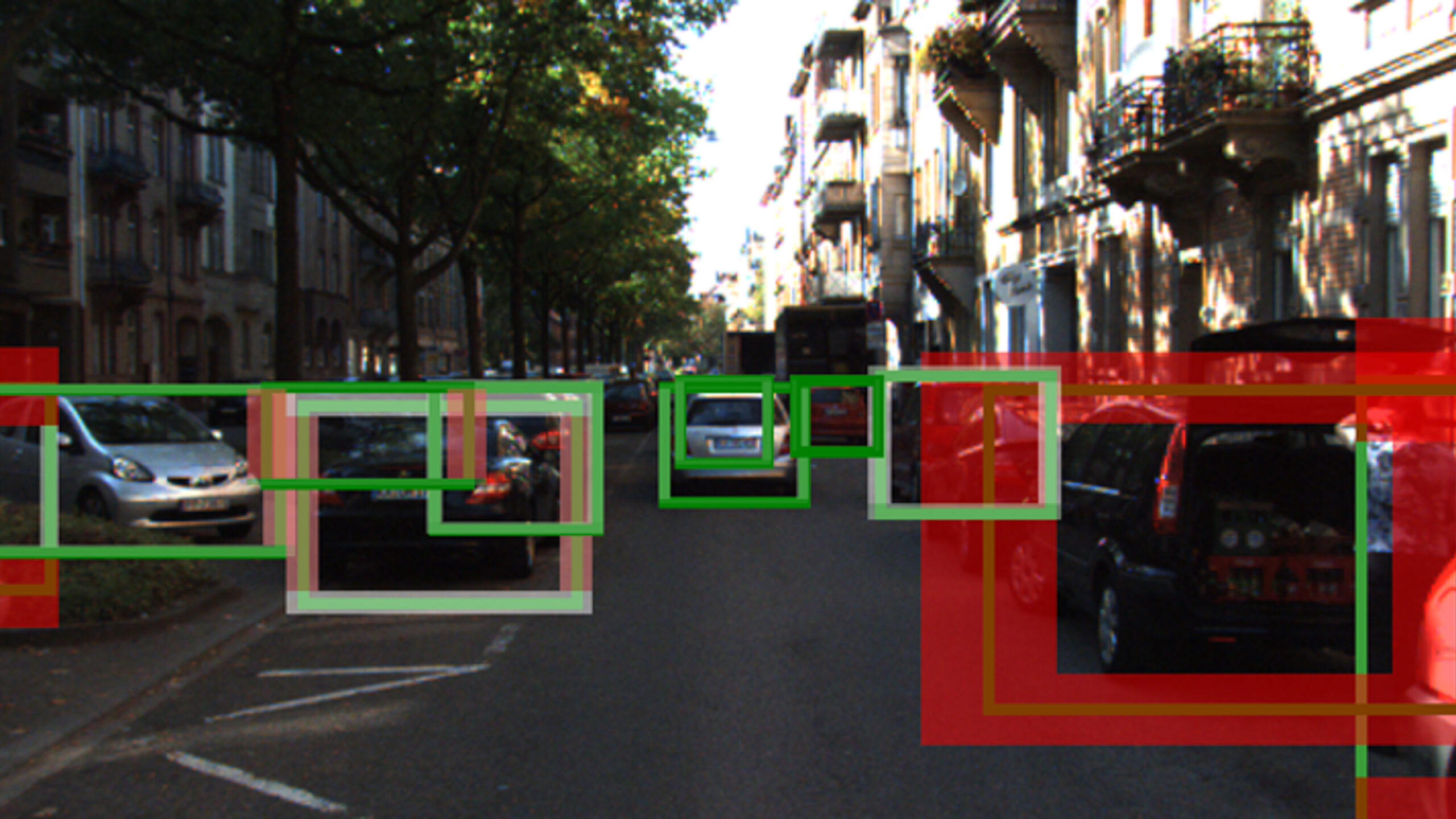

Abbildung 1: Bei der Unsicherheitsschätzung beim autonomen Fahren werden Kamerabilder analysiert. Den gefundenen Objekten wird eine Unsicherheit zugeordnet, die über die Dickeund Farbe des Rahmens um das Objekt dargestellt wird. So wird das Objekt rechts mit dickem rotem Rahmen als sehr unsicher eingestuft.

Abbildung 2: Bei diesem Beispiel detektiert das System zunächst vier Objekte, wovon nur zwei korrekt sind und demnach als True Positive (TP) bezeichnet werden. Die beiden Falsch-Vorhersagen, also False Positives (FP), lassen sich jedoch herausfiltern, da sie mit einer hohen Unsicherheitsschätzung einhergehen.

Demonstrator: Wasserstein-Dropout im Autonomen Fahren

-

- Loggen Sie sich auf der AI4Europe-Plattform hier ein. Wie das geht, zeigt folgendes Video.

- Rufen Sie den Wasserstein-Dropout Demonstrator aus dem AI4EU-Marketplace hier auf

- Wählen Sie oben rechts „Deploy for Execution“ und „AI-Lab Playground“

- Sie werden zum „AI-Lab Playground“ weitergeleitet, eine Ausführungsumgebung für Machine-Learning Anwendungen.

- Rufen sie den Demonstrator auf: Klicken Sie in der Zeile „uncertaintydemonstrator“ auf das Symbol der Spalte „WebUI/Folder“

- Sie werden zur Uncertainty-Demonstrator Applikation weitergeleitet

Sie möchten Sich zuerst einen Überblick über den Demonstrator verschaffen? Das folgende Video leitet Sie durch unseren Demonstrator und zeigt die

beispielhafte Anwendung der Wasserstein-Dropout Methode im Autonomen Fahren